Алгоритмы google панда пингвин

Введение: Мир алгоритмов Google и их влияние на SEO

В постоянно меняющемся мире SEO понимание алгоритмов Google является краеугольным камнем успешного продвижения. Каждый вебмастер и SEO-специалист знает, что поисковая выдача не статична: она постоянно эволюционирует под влиянием новых правил и обновлений. Цель этой статьи — предоставить полное руководство по основным фильтрам и санкциям Google, объяснить их механизм действия и дать практические советы по оптимизации. Вы узнаете, как эти алгоритмы формируют ранжирование, как избежать штрафов и поддерживать высокие позиции.

Что такое алгоритмы и фильтры Google: Различия и цели

Для эффективного продвижения в поисковой системе Google крайне важно понимать разницу между алгоритмами и фильтрами. Хотя оба понятия направлены на улучшение качества выдачи и борьбу со спамом, их функции и методы воздействия на ранжирование сайтов различны. Алгоритмы Google — это набор правил и формул, используемых для оценки и сортировки миллиардов веб-страниц, определяющих их позицию в результатах поиска. Они постоянно обновляются (например, Core Updates), чтобы обеспечивать наиболее релевантный контент пользователям. Их главная цель — улучшить пользовательский опыт, предоставляя наиболее точные и полезные ответы на запросы.

Фильтры Google, в свою очередь, представляют собой более специфические механизмы, которые накладывают санкции на сайты, нарушающие рекомендации для вебмастеров. Они не влияют на весь индекс, а применяются к конкретным сайтам или их частям, значительно снижая их видимость или полностью исключая из поисковой выдачи. Фильтры активируются при выявлении нарушений, таких как манипуляции со ссылками или низкокачественный контент.

Основные различия между алгоритмами и фильтрами Google:

- Алгоритмы: постоянная основа ранжирования, которая оценивает все сайты.

- Фильтры: применяются как санкции за конкретные нарушения, выборочно влияя на провинившиеся ресурсы.

- Цель алгоритмов: улучшение релевантности и качества выдачи в целом.

- Цель фильтров: наказание за манипуляции и борьба со спамом, поддержание честной конкуренции.

Ключевые алгоритмы Google, которые должен знать каждый SEO-специалист (2024-2025)

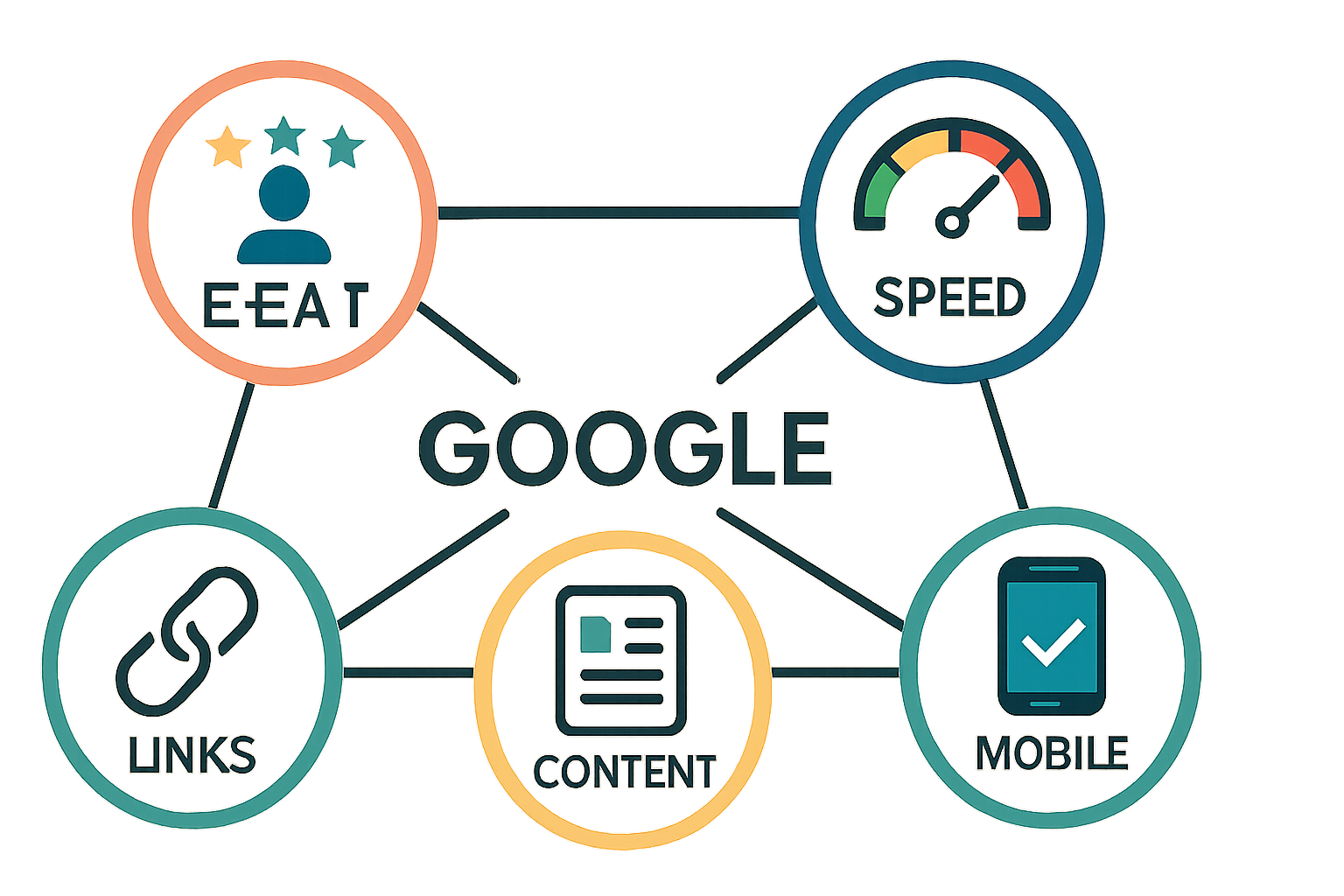

Поисковая система Google постоянно совершенствует свои алгоритмы, чтобы предоставлять пользователям наиболее релевантные и качественные результаты. Для SEO-специалистов и вебмастеров критически важно быть в курсе этих изменений и понимать, как каждый алгоритм влияет на ранжирование. В этом разделе мы подробно разберем наиболее значимые алгоритмы Google, их функционал, дату внедрения и основные принципы работы, уделяя особое внимание актуальным апдейтам.

Таблица сравнения основных алгоритмов Google

| Алгоритм | Дата внедрения (примерно) | Основная цель | На что влияет |

|---|---|---|---|

| Panda | 2011 год | Оценка качества контента | Качество, уникальность и релевантность контента; борьба с дубликатами и переспамом. |

| Penguin | 2012 год | Борьба с неестественными ссылками | Качество и естественность ссылочного профиля; борьба с покупными ссылками и спамом в анкорах. |

| Hummingbird (Колибри) | 2013 год | Понимание семантики и интента запросов | Способность Google понимать смысл запроса, а не только ключевые слова; релевантность контента интенту пользователя. |

| RankBrain | 2015 год | Искусственный интеллект для обработки запросов | Понимание сложных и ранее неизвестных запросов; оценка поведенческих факторов. |

| Mobile First Indexing | 2016 год (постепенно) | Приоритет мобильной версии сайта | Ранжирование сайтов на основе их мобильной версии; мобильная адаптация и скорость загрузки. |

| Fred | 2017 год | Борьба с агрессивной рекламой и низкокачественным контентом | Сайты с чрезмерным количеством рекламы, низким качеством контента и плохим пользовательским опытом. |

| BERT | 2019 год | Улучшенное понимание естественного языка | Более глубокое понимание контекста слов в запросах и на страницах. |

| Core Updates | Регулярно (несколько раз в год) | Глобальное обновление ядра ранжирования | Общее качество сайта, E-E-A-T, пользовательский опыт, общая релевантность и авторитетность. |

| Page Experience (Core Web Vitals) | 2021 год | Оценка пользовательского опыта на странице | Скорость загрузки (LCP), интерактивность (FID), визуальная стабильность (CLS), мобильная адаптация, HTTPS. |

| MUM | 2021 год | Многозадачная унифицированная модель | Понимание сложных запросов, требующих нескольких этапов поиска, и предоставление ответов на разных языках и в разных форматах. |

| SpamBrain | 2022 год | Противодействие спаму | Эффективное выявление и нейтрализация различных видов спама, включая ссылочный и контентный. |

| System of helpful content (Система полезного контента) | 2022 год | Приоритизация полезного, ориентированного на человека контента | Сайты, созданные в первую очередь для людей, а не для поисковых систем; ценность и уникальность информации. |

Google Panda: Страж качества контента

Panda, запущенная в 2011 году, стала одним из первых крупных алгоритмов Google, направленных на борьбу с низкокачественным контентом. Её цель — выявлять и понижать в ранжировании сайты с дублированным, неуникальным, некачественным или переоптимизированным текстом, а также с чрезмерным количеством рекламы. Если ваш сайт попал под Панду, вы можете заметить резкое падение органического трафика и позиций. Признаки включают высокий показатель отказов, низкое время на сайте, а также отсутствие ценности для пользователя. Для выхода из-под фильтра необходимо провести тщательный аудит контента, удалить или улучшить некачественные страницы, обеспечить уникальность и полезность информации, убрать переспам ключевыми словами и улучшить пользовательский опыт. Асессоры Google играют ключевую роль в оценке качества. Регулярная проверка на дубли и создание высококачественного, ориентированного на пользователя контента — лучшая профилактика.

Google Penguin: Борьба с некачественными ссылками

Penguin, впервые представленный в 2012 году, нацелен на выявление и наказание сайтов, использующих манипулятивные техники построения ссылочного профиля. Этот алгоритм борется с неестественными ссылками, покупными ссылками, спамом в анкорах и другими попытками искусственно завысить ранжирование. Симптомы попадания под Пингвина включают резкое падение трафика и позиций, особенно по ключевым запросам, где использовались некачественные бэклинки. Для диагностики и снятия санкций необходимо провести полный аудит ссылочного профиля с использованием таких инструментов, как Ahrefs и Majestic. Выявленные токсичные ссылки следует удалить или отклонить с помощью Google Disavow Tool. Построение здорового и естественного ссылочного профиля, основанного на качественных донорах, — единственный путь к долгосрочному успеху.

Google Hummingbird (Колибри): Понимание семантики и запросов

Запущенный в 2013 году, Hummingbird (Колибри) ознаменовал собой значительный сдвиг в способности Google понимать запросы пользователей. Вместо простого поиска по ключевым словам, Колибри фокусируется на семантике и интенте запроса, позволяя поисковой системе выдавать более точные результаты даже для сложных и разговорных фраз. Он помогает Google понимать взаимосвязь слов в запросе, а не только их наличие. Оптимизация контента под Колибри означает создание глубоких, информативных статей, которые полностью отвечают на вопросы пользователя, используя LSI-слова и контекстуально релевантную лексику, а не простое повторение ключевых фраз.

RankBrain, BERT, MUM: Искусственный интеллект в ранжировании

С развитием искусственного интеллекта (ИИ), Google внедрил ряд мощных алгоритмов, таких как RankBrain (2015), BERT (2019) и новейший MUM (2021). RankBrain использует машинное обучение для интерпретации запросов, особенно редких и сложных, улучшая понимание поисковой системы. BERT (Bidirectional Encoder Representations from Transformers) углубил это понимание, позволяя Google лучше распознавать контекст слов в предложениях. MUM (Multitask Unified Model) пошёл ещё дальше, обеспечивая многозадачность и мультимодальность, что позволяет Google отвечать на сложные вопросы, требующие информации из разных источников и на разных языках. Эти алгоритмы подчеркивают важность естественного языка, глубокого раскрытия темы и предоставления исчерпывающей информации для пользователей.

Core Updates и их влияние на глобальное ранжирование

Core Updates (обновления ядра) — это масштабные изменения в алгоритмах Google, которые происходят несколько раз в год и могут заметно влиять на ранжирование сайтов. В отличие от более специфических фильтров, Core Updates затрагивают общие принципы оценки качества. После такого обновления сайт может как вырасти, так и потерять позиции. Google не дает детальных инструкций по восстановлению, но всегда подчеркивает важность создания высококачественного, полезного контента, который демонстрирует E-E-A-T (Опыт, Экспертность, Авторитетность, Надежность). Фокус на улучшении общего пользовательского опыта и соответствие рекомендациям для вебмастеров является ключевым для успешного прохождения этих обновлений.

Фильтры и санкции Google: Как их диагностировать и снять

Попадание под фильтры или санкции Google может стать серьезным испытанием для любого сайта, приводя к резкому падению трафика и позиций в поисковой выдаче. Важно не паниковать, а действовать системно. Это практическое руководство поможет вам выявить и устранить технические проблемы и другие нарушения, чтобы обеспечить выход из-под фильтра.

Чек-лист для проверки сайта на наличие санкций Google:

- Проверка Google Search Console: В первую очередь, внимательно изучите раздел «Меры, принятые вручную» и «Сообщения» в Google Search Console. Здесь Google напрямую уведомляет о ручных санкциях.

- Анализ трафика в Google Analytics: Отслеживайте резкие падения органического трафика. Сопоставляйте даты падений с датами глобальных обновлений алгоритмов Google или внедрением фильтров.

- Анализ индексации: Проверьте количество проиндексированных страниц в Google Search Console. Резкое сокращение может указывать на проблемы с индексацией или применение фильтра.

- Аудит ссылочного профиля: Используйте аналитические инструменты (Ahrefs, Majestic) для выявления неестественных или токсичных ссылок, ведущих на ваш сайт.

- Аудит контента: Оцените качество, уникальность и релевантность контента на сайте. Ищите дублированный, некачественный или переоптимизированный текст.

- Проверка юзабилити и технических ошибок: Убедитесь в отсутствии критических технических проблем, таких как медленная загрузка, ошибки 404, неработающие ссылки, проблемы с мобильной адаптацией.

- Мониторинг позиций: Используйте сервисы отслеживания позиций, чтобы выявить резкие просадки по ключевым запросам.

Инструменты для диагностики санкций

Для эффективной диагностики и мониторинга состояния сайта после потенциальных санкций или фильтров, необходимо активно использовать специализированные инструменты. Google Search Console является вашим основным помощником, предоставляя критически важную информацию о проблемах с индексацией, ошибках сканирования и, самое главное, прямые предупреждения о ручных санкциях. Google Analytics позволяет отслеживать изменения в трафике, помогая соотнести падения с возможными обновлениями алгоритмов. Дополнительные сервисы, такие как Ahrefs и Majestic, незаменимы для анализа ссылочного профиля. Инструмент Panguin Tool может помочь визуализировать влияние обновлений Google на ваш трафик, накладывая даты апдейтов на график посещаемости.

Распространенные типы ручных санкций и их устранение

Ручные санкции накладываются сотрудниками Google после выявления серьезных нарушений рекомендаций для вебмастеров. Они могут быть вызваны различными причинами, включая спам по ссылкам (неестественные ссылки), спам в контенте (скрытый текст, избыточное количество ключевых слов), клоакинг (показ разного контента поисковым роботам и пользователям), а также переоптимизация. При получении уведомления о ручных санкциях в Google Search Console, необходимо немедленно приступить к устранению ошибок. Для борьбы с неестественными ссылками используйте Disavow Tool, чтобы отклонить подозрительные ссылки. После исправления всех нарушений нужно отправить запрос на пересмотр в Google. Процесс может занять время, но тщательное исправление проблем значительно увеличивает шансы на выход из-под фильтра.

Как выйти из-под фильтров Panda и Penguin: Практические кейсы

Выход из-под фильтра Panda требует систематической работы над качеством контента. Это включает удаление или переработку дублированного, некачественного и тонкого контента, улучшение структуры страниц, повышение уникальности и релевантности информации. Важно также улучшить юзабилити сайта, снизить показатель отказов и увеличить время, проводимое пользователями на сайте. Для выхода из-под фильтра Penguin необходимо сосредоточиться на очистке ссылочного профиля. Это означает выявление и удаление всех неестественных и спамных ссылок, а также использование Disavow Tool для отклонения тех, что невозможно удалить. После этого следует сосредоточиться на построении естественной ссылочной массы через высококачественный контент и его распространение. В обоих случаях выход из-под фильтра — это долгосрочный процесс, требующий последовательных усилий и терпения, но он возможен при правильном подходе к устранению ошибок и улучшению сайта в целом.

Особые алгоритмы Google: Песочница, Mobile First, Голубь, Опоссум

Помимо основных гигантов, таких как Panda и Penguin, Google использует множество других, менее очевидных, но не менее важных алгоритмов, которые оказывают существенное влияние на ранжирование в зависимости от типа сайта и ниши. Понимание их работы поможет избежать проблем и эффективно оптимизировать ресурс.

Google Sandbox (Песочница): Испытание для молодых сайтов

Google Sandbox, или Песочница, — это неофициальный термин, описывающий период, в течение которого молодые сайты испытывают трудности с ранжированием по высокочастотным запросам. Это не строгий фильтр, а скорее период недоверия со стороны Google, когда поисковая система внимательно изучает новый ресурс, его контент, ссылочный профиль и поведенческие факторы. Цель Песочницы — предотвратить быстрый взлет некачественных или спамных сайтов. Длительность пребывания в Sandbox может варьироваться от нескольких месяцев до года.

Рекомендации для молодых сайтов по работе с Google Sandbox:

- Создавайте высококачественный, уникальный и полезный контент.

- Развивайте естественный ссылочный профиль, избегая агрессивной покупки ссылок.

- Обеспечьте отличный пользовательский опыт и высокую юзабилити сайта.

- Регулярно публикуйте новый контент и активно взаимодействуйте с аудиторией.

- Терпение — главный союзник: сосредоточьтесь на качестве, и со временем Google начнет доверять вашему ресурсу.

Mobile First Indexing: Приоритет мобильной версии

Mobile First Indexing — это подход Google, при котором основное сканирование, индексация и ранжирование сайтов осуществляются на основе их мобильной версии. Это означает, что для Google мобильная версия сайта является основной, даже если пользователь заходит с десктопа. Если ваш сайт не адаптирован под мобильные устройства, это может негативно сказаться на его позициях. Важно обеспечить быструю скорость загрузки, отзывчивый дизайн и удобство использования на смартфонах и планшетах.

Google Pigeon (Голубь): Влияние на локальное SEO

Google Pigeon, запущенный в 2014 году, значительно повлиял на локальное SEO. Этот алгоритм улучшил ранжирование местных компаний в поисковой выдаче, теснее интегрировав локальные результаты с основными алгоритмами. Голубь учитывает местоположение пользователя, его близость к бизнесу и релевантность запроса. Для успешного локального SEO критически важна оптимизация Google My Business, использование локальных ключевых слов и получение отзывов.

Google Possum (Опоссум): Уточнение локального поиска

Google Possum, внедренный в 2016 году, стал дальнейшим развитием локального поиска. Он еще больше усилил зависимость локальных результатов от физического местоположения пользователя и уточнил, как Google фильтрует бизнесы с похожими адресами. Например, несколько врачей в одном здании могут не отображаться в локальной выдаче одновременно. Опоссум также стал более строго фильтровать результаты, чтобы избежать дублирования и предложить максимально разнообразные варианты.

Google Fred: Борьба с агрессивной монетизацией

Fred, появившийся в 2017 году, был нацелен на сайты с агрессивной монетизацией и низким качеством контента. Этот алгоритм наказывал ресурсы, которые были перегружены рекламой, использовали всплывающие окна и создавали контент исключительно для получения дохода от рекламы, а не для предоставления ценности пользователям. Для защиты от Fred необходимо сбалансировать монетизацию с качеством контента и пользовательским опытом.

Фильтры Яндекса: Обзор и сравнение с алгоритмами Google

Хотя основное внимание в SEO часто уделяется алгоритмам Google, для сайтов, ориентированных на русскоязычную аудиторию, крайне важно понимать и учитывать особенности Яндекса. Российский поисковик имеет свои уникальные фильтры и санкции, которые могут серьезно повлиять на ранжирование и трафик. Рассмотрим наиболее значимые из них и проведем сравнение с аналогами в Google.

Сравнительная таблица фильтров Google и Яндекс

| Название фильтра (Яндекс) | Цель | На что влияет | Аналог в Google | Рекомендации по снятию / избежанию |

|---|---|---|---|---|

| АГС (например, АГС-40, без цифр) | Борьба с некачественными, созданными только для SEO, сайтами (дорвеи, сателлиты, сайты без ценности). | Полное исключение сайта из индекса или значительное снижение его видимости. Уменьшение ИКС. | Panda, SpamBrain, System of helpful content | Создание уникального, полезного контента для пользователей, улучшение юзабилити, наращивание естественного ссылочного профиля. |

| Минусинск | Борьба с покупными ссылками и манипуляциями ссылочным профилем. | Резкое падение позиций по ключевым запросам. | Penguin | Удаление или отклонение покупных/неестественных ссылок, создание естественного ссылочного профиля. |

| Переспам | Борьба с избыточным использованием ключевых слов в тексте. | Понижение позиций конкретных страниц или всего сайта по запросам с переспамом. | Panda (в части контента), Fred | Сокращение плотности ключевых слов, использование синонимов, улучшение читабельности текста. |

| Аффилиат фильтр | Борьба с несколькими сайтами одного владельца, продвигающимися по одинаковым запросам. | Полное исключение аффилированных сайтов из выдачи по общим запросам. | Не имеет прямого аналога, но Google также борется с сетями сайтов. | Максимальное различие сайтов по структуре, дизайну, контенту, ассортименту, юридическому лицу. |

| Накрутка поведенческих факторов | Борьба с искусственным улучшением поведенческих метрик. | Резкое падение позиций, исключение из выдачи. | RankBrain (в части оценки поведенческих факторов), SpamBrain | Прекращение накрутки, улучшение реального пользовательского опыта на сайте. |

Основные фильтры Яндекса и их особенности

АГС: Борьба за качество

АГС — один из старейших и наиболее известных фильтров Яндекса, направленный на борьбу с некачественными сайтами, созданными исключительно для манипуляции поисковой выдачей. Ранние версии (АГС-17, АГС-30, АГС-40) исключали сайты из индекса. Современный АГС «без цифр» фокусируется на сайтах, которые не несут ценности для пользователя, имеют дублированный контент или представляют собой дорвеи. Попадание под АГС может привести к значительному снижению ИКС (Индекса Качества Сайта) и потере позиций. Для выхода из-под санкций Яндекса по АГС необходимо кардинально улучшить качество сайта, создать уникальный и полезный контент, а также обеспечить хорошую юзабилити.

Минусинск: Против покупных ссылок

Минусинск, запущенный в 2015 году, стал ответом Яндекса на активное использование покупных ссылок. Этот фильтр наказывает сайты, чей ссылочный профиль признан неестественным. В отличие от Penguin Google, который может снизить вес конкретных ссылок, Минусинск накладывает санкции на весь сайт, приводя к резкому падению позиций. Для снятия Минусинска необходимо удалить или максимально сократить количество покупных ссылок и сосредоточиться на получении естественных.

Переспам: Чистота текста

Фильтр Переспам наказывает страницы за избыточное использование ключевых слов, что делает текст неестественным и трудным для чтения. Это аналог части функций Google Panda. Для избежания или снятия Переспама следует снизить плотность ключевых слов, использовать синонимы, LSI-фразы и обеспечить естественное звучание текста.

Аффилиат фильтр: Один владелец – один сайт

Аффилиат фильтр Яндекса нацелен на выявление и исключение из поисковой выдачи аффилированных сайтов, то есть нескольких ресурсов, принадлежащих одному владельцу и продвигающихся по идентичным или очень похожим запросам. Яндекс считает, что это создает нечестную конкуренцию. Чтобы избежать этого фильтра, необходимо максимально дифференцировать свои проекты по ассортименту, дизайну, контенту и даже юридическим данным.

Понимание этих фильтров и санкций позволяет вебмастерам не только оперативно реагировать на проблемы, но и строить долгосрочную стратегию продвижения, ориентированную на качество и пользовательский опыт, что является универсальным подходом как для Google, так и для Яндекса.

Часто задаваемые вопросы (FAQ)

В этом разделе мы собрали ответы на наиболее популярные вопросы, которые возникают у вебмастеров и SEO-специалистов по поводу алгоритмов, фильтров и санкций Google. Надеемся, это поможет вам лучше понять принципы работы поисковой системы и эффективно управлять своим сайтом.

Как узнать, под каким фильтром Google находится мой сайт?

В первую очередь проверьте Google Search Console в разделе «Меры, принятые вручную». Если там пусто, проанализируйте резкие падения трафика в Google Analytics и сопоставьте их с датами крупных обновлений алгоритмов Google (например, Core Updates). Используйте сторонние инструменты, такие как Panguin Tool, для визуализации влияния обновлений. Также обратите внимание на основные LSI-слова, такие как падение позиций по определённым запросам или типу контента, что может указывать на конкретный фильтр.

Как долго снимаются санкции Google?

Сроки снятия санкций сильно варьируются. Ручные санкции могут быть сняты в течение нескольких дней или недель после успешного запроса на пересмотр и устранения всех проблем. Автоматические фильтры (например, Panda или Penguin) требуют длительной работы по улучшению сайта. Выход из-под фильтра может занять от нескольких недель до нескольких месяцев, а иногда и дольше, так как Google должен повторно просканировать и переоценить сайт.

Можно ли полностью избежать всех фильтров Google?

Полностью избежать всех алгоритмов и фильтров Google невозможно, поскольку они являются неотъемлемой частью работы поисковой системы. Однако, следуя рекомендациям Google для вебмастеров, создавая высококачественный, полезный и релевантный контент, обеспечивая отличный пользовательский опыт и строя естественный ссылочный профиль, вы значительно снижаете риски попадания под санкции. Основная стратегия — фокусироваться на нуждах пользователя, а не на манипуляциях поисковой системой.

Что такое «Песочница Google» и как быстро из неё выйти?

Песочница Google (Sandbox) — это неофициальный термин, описывающий период, когда новые сайты испытывают трудности с ранжированием. Это не фильтр в прямом смысле, а период недоверия. Быстро выйти из неё сложно, так как это требует времени для формирования доверия. Сосредоточьтесь на регулярной публикации качественного контента, получении естественных ссылок и улучшении пользовательских метрик. Со временем Google начнёт доверять вашему ресурсу. LSI-слова, такие как молодые сайты и проверка сайта, часто ассоциируются с этим этапом.

Как часто Google обновляет свои алгоритмы?

Google постоянно вносит мелкие изменения в свои алгоритмы ежедневно, но крупные обновления (Core Updates) происходят несколько раз в год. Кроме того, есть специфические алгоритмы, такие как Panda и Penguin, которые могут обновляться независимо или быть интегрированы в основное ядро. Всегда следите за официальными объявлениями и новостями в SEO-сообществе.

Заключение: Как успешно работать с Google в 2025 году

Успешное SEO-продвижение в 2025 году и далее требует не просто адаптации к текущим алгоритмам Google и фильтрам, а глубокого понимания философии поисковой системы. Ключевая стратегия — это создание ценности для пользователя. Фокусируйтесь на высоком качестве контента, превосходном пользовательском опыте, прозрачности и авторитетности. Откажитесь от манипулятивных тактик и инвестируйте в долгосрочное развитие своего ресурса. Только такой подход обеспечит устойчивый рост трафика и позиций, делая ваш сайт релевантным для постоянно меняющегося будущего SEO.

Комментарии

Оставить комментарий